인공지능(AI) 기술이 급속히 발전하면서 기존 평가 방식의 한계가 드러나 미국 주요 기술기업들이 AI 모델을 테스트하고 평가하는 새로운 방식을 모색하고 있다.

인공지능(AI) 관련 이미지 [로이터 연합뉴스 자료사진]

인공지능(AI) 관련 이미지 [로이터 연합뉴스 자료사진]

9일(현지시간) 파이낸셜타임스(FT)에 따르면, 기존 벤치마크 테스트에서 AI 신모델들의 정확도가 90%대를 기록하면서 더 복잡하고 정교한 평가 방식의 필요성이 대두되고 있다.

메타플랫폼의 한 관계자는 "업계의 발전 속도가 극히 빠르다"면서 "측정 능력이 포화하기 시작했으며 AI 신모델을 평가하기가 점점 어려워지고 있다"고 지적했다.

오픈AI, 마이크로소프트, 메타, 앤스로픽 등은 최근 인간을 대신해 자동으로 업무를 수행할 수 있는 'AI 에이전트' 구축 계획을 발표했다. 이러한 새로운 기술의 등장으로 평가 방식의 혁신이 시급해졌다.

이에 주요 기술기업들은 자체적인 벤치마크를 개발하고 있다. 다만 업계 일각에서는 공개적인 테스트가 없는 상황에서 각 기업의 AI 기술을 객관적으로 비교하기 어렵다는 우려가 제기되고 있다.

이런 상황에서 기존 벤치마크 중 하나인 'SWE-bench Verified'는 지난 8월 오픈AI 등의 의견을 반영해 업데이트를 진행했다. 이 테스트는 개발자 플랫폼 '깃허브' 등에서 가져온 실제 문제를 활용하고 있다.

새로운 테스트에서 오픈AI의 최신 AI 모델인 GPT-4는 41.4%의 문제를 해결했으며, 앤스로픽의 '클로드 3.5 소넷'은 49%의 정답률을 기록했다.

한편 AI 세이프티의 댄 헨드릭스는 "테스트가 공개되지 않으면 재계나 사회 전반에서 비교에 대해 말하기 어렵다"며 공개된 평가 기준의 필요성을 강조했다.

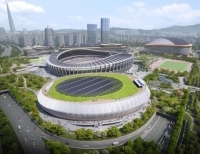

잠실운동장, 스포츠·MICE 복합지구로 재탄생…2032년 완공 목표

서울 잠실종합운동장 일대가 스포츠·MICE(회의·관광·컨벤션·전시) 복합공간으로 조성돼 동북아 대표 MICE 거점으로 탈바꿈한다. 서울시는 13일 제10차 건축위원회에서 ‘잠실 스포츠·MICE 복합공간 조성사업’ 건축심의를 통과시켰다고 밝혔다.이번 사업은 잠실 주경기장의 상징성을 살리면서도 서울국제교류복...

잠실운동장, 스포츠·MICE 복합지구로 재탄생…2032년 완공 목표

서울 잠실종합운동장 일대가 스포츠·MICE(회의·관광·컨벤션·전시) 복합공간으로 조성돼 동북아 대표 MICE 거점으로 탈바꿈한다. 서울시는 13일 제10차 건축위원회에서 ‘잠실 스포츠·MICE 복합공간 조성사업’ 건축심의를 통과시켰다고 밝혔다.이번 사업은 잠실 주경기장의 상징성을 살리면서도 서울국제교류복...

정부-이통사, AI 3대 강국 도약 위해 3,000억 투자 확대

과학기술정보통신부가 이동통신 3사와 함께 인공지능 분야 집중 투자를 위한 3,000억 원 규모의 한국정보통신기금 자펀드 결성을 발표했다. 과기정통부는 12일 서울 웨스틴조선호텔에서 '정부-이통사 인공지능 투자협력 선언식'을 개최하고 민관 합동 AI 투자 확대 계획을 공식 발표했다. 이날 행사는 한국정보통신기금(KIF)의 존속기간 .

정부-이통사, AI 3대 강국 도약 위해 3,000억 투자 확대

과학기술정보통신부가 이동통신 3사와 함께 인공지능 분야 집중 투자를 위한 3,000억 원 규모의 한국정보통신기금 자펀드 결성을 발표했다. 과기정통부는 12일 서울 웨스틴조선호텔에서 '정부-이통사 인공지능 투자협력 선언식'을 개최하고 민관 합동 AI 투자 확대 계획을 공식 발표했다. 이날 행사는 한국정보통신기금(KIF)의 존속기간 .

넷플릭스 'K팝 데몬 헌터스' OST 'Golden', 빌보드 핫100 정상

넷플릭스 애니메이션 영화 'K팝 데몬 헌터스' 사운드트랙 'Golden'이 빌보드 핫100 차트에서 1위를 차지했다.미국 빌보드가 11일(현지시간) 발표한 8월 16일 자 핫100 차트에 따르면, HUNTR/X의 'Golden'이 지난주 2위에서 한 계단 상승해 첫 번째 1위를 기록했다. 이 곡은 EJAE, 오드리 누나(Audrey Nuna), REI AMI 등 3명의 가수가 목소리를...

넷플릭스 'K팝 데몬 헌터스' OST 'Golden', 빌보드 핫100 정상

넷플릭스 애니메이션 영화 'K팝 데몬 헌터스' 사운드트랙 'Golden'이 빌보드 핫100 차트에서 1위를 차지했다.미국 빌보드가 11일(현지시간) 발표한 8월 16일 자 핫100 차트에 따르면, HUNTR/X의 'Golden'이 지난주 2위에서 한 계단 상승해 첫 번째 1위를 기록했다. 이 곡은 EJAE, 오드리 누나(Audrey Nuna), REI AMI 등 3명의 가수가 목소리를...

최휘영 장관 “케이-뮤지컬, 창작부터 해외진출까지 전 과정 지원”

문화체육관광부 최휘영 장관이 대학로를 찾아 창작 뮤지컬 <스웨그에이지 외쳐, 조선!> 제작진을 격려하고, 케이-뮤지컬의 창작 단계부터 해외 진출까지 이어지는 지원 체계와 산업 생태계 확충을 약속했다.일 서울 종로구 대학로 홍익대학교아트센터 대극장을 방문해 뮤지컬 <스웨그에이지 외쳐, 조선!>을 관람한 뒤 출연진과 관계...

최휘영 장관 “케이-뮤지컬, 창작부터 해외진출까지 전 과정 지원”

문화체육관광부 최휘영 장관이 대학로를 찾아 창작 뮤지컬 <스웨그에이지 외쳐, 조선!> 제작진을 격려하고, 케이-뮤지컬의 창작 단계부터 해외 진출까지 이어지는 지원 체계와 산업 생태계 확충을 약속했다.일 서울 종로구 대학로 홍익대학교아트센터 대극장을 방문해 뮤지컬 <스웨그에이지 외쳐, 조선!>을 관람한 뒤 출연진과 관계...

이상경 국토부 차관 “건설현장 지하안전·폭염 대비 철저”

국토교통부 이상경 제1차관은 7일 안양시 만안구 월곶~판교 복선전철 6공구 현장을 찾아 지하안전대책과 혹서기 온열질환 예방 대책을 점검하고, 안전을 우려하는 현장 목소리를 적극 반영해 철저한 관리에 나설 것을 주문했다.이날 방문한 공구는 총 연장 3.14km 규모로, 이 중 2.9km가 터널 구간이며 환기구 1개소, 정거장 1개소가 포함돼 있다....

이상경 국토부 차관 “건설현장 지하안전·폭염 대비 철저”

국토교통부 이상경 제1차관은 7일 안양시 만안구 월곶~판교 복선전철 6공구 현장을 찾아 지하안전대책과 혹서기 온열질환 예방 대책을 점검하고, 안전을 우려하는 현장 목소리를 적극 반영해 철저한 관리에 나설 것을 주문했다.이날 방문한 공구는 총 연장 3.14km 규모로, 이 중 2.9km가 터널 구간이며 환기구 1개소, 정거장 1개소가 포함돼 있다....

중소기업부, 관세 현안·수출 애로 해소 위한 정책현장투어 실시

중소벤처기업부(장관 한성숙, 이하 중기부)는 8월 6일 중소기업 분야 정책현장투어 두 번째 행선지로 경기도 소재 `실리콘투` 물류센터를 방문해 수출 중소기업 관계자들과 간담회를 개최하고 현장 애로사항을 청취했다.이번 정책현장투어는 중기부 장관이 주요 정책 영역과 밀접한 현장을 직접 찾아가 현장의 목소리를 정책으로 담아내기 .

중소기업부, 관세 현안·수출 애로 해소 위한 정책현장투어 실시

중소벤처기업부(장관 한성숙, 이하 중기부)는 8월 6일 중소기업 분야 정책현장투어 두 번째 행선지로 경기도 소재 `실리콘투` 물류센터를 방문해 수출 중소기업 관계자들과 간담회를 개최하고 현장 애로사항을 청취했다.이번 정책현장투어는 중기부 장관이 주요 정책 영역과 밀접한 현장을 직접 찾아가 현장의 목소리를 정책으로 담아내기 .